第十一回 画像認識におけるディープラーニング

人工知能の一分野として、入力された写真に何が写っているのかをコンピュータに判別させる技術の研究があり、古くから様々な取り組みが行われてきました。 例えば動物が写っている写真がたくさんあった場合、人間が見ても判別に迷うものがいくつか混じっていたりするもので、これをコンピュータのアルゴリズムにより高い精度で判別させることは難しい問題で、従来の技術では解決できていませんでした。 近年、ディープラーニングの技術を使うと、かなり高い精度で画像の分類が行えることがわかってきました。 ディープラーニングによる画像認識の進め方を簡単に説明すると、以下のようになります。

1 学習データセットの準備

システムの学習に使用する画像ファイルを集めます。 例えば、犬と猫の分類を行えるシステムを作りたい場合、犬または猫が写った画像をたくさん集めます。 さらに、それぞれの写真がどちらに分類されるべきかをまとめたデータを準備します。 正解を与えるデータの集合を教師データと呼びます。 画像データと教師データからなる集合を学習データセットと呼びます。

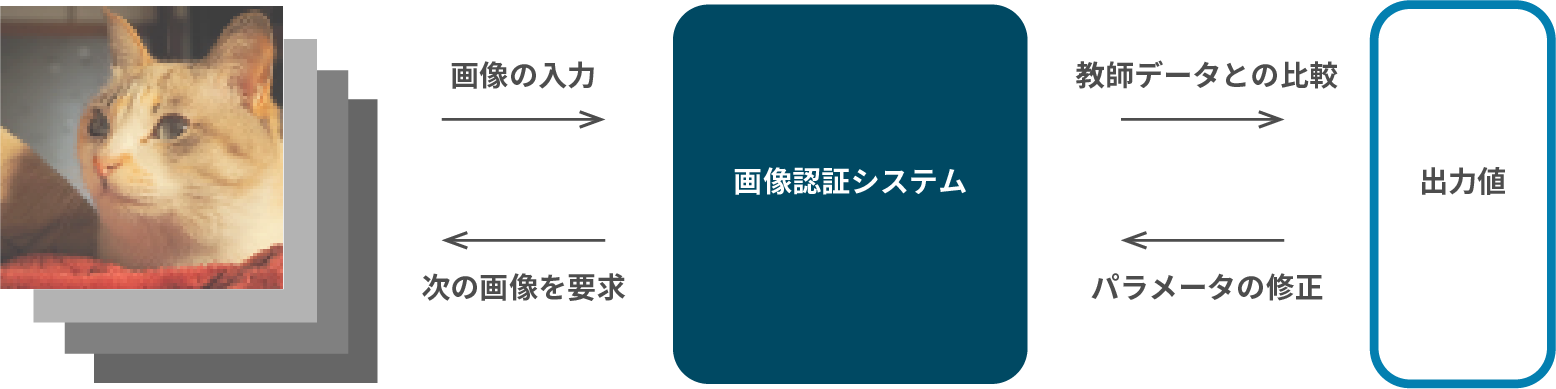

2 学習の実施

システムに学習データセットを与え、出力値が教師データに近づくように、システム内にあるパラメータの値を調整します。 大量の画像ファイルと教師データの組み合わせを与え、コンピュータに繰り返し計算を行わせることで、どの画像を与えても正解が得られるシステムに近づいていきます。

3 結果の検証

システムに検査用の画像ファイルを与え、その結果を調べます。 この目的で使用するデータセットを検査データセットと呼びます。 学習によって得られた画像認識精度を確認することができます。